Subtotal 0 рсд

U svom zapaženom izlaganju na NeurIPS 2024 konferenciji u Vankuveru, Ilya Sutskever, jedan od suosnivača OpenAI-a i bivši glavni naučnik u Open AI (zvanično je napustio Open AI i osnovao svoju kompaniju Safe Superintelligence, u junu 2024. dok je već u septembru prikupio 1 milijardu $), izneo je provokativne uvide o trenutnom stanju i budućnosti veštačke inteligencije. Sutskever, koji je značajno doprineo razvoju najpoznatijih jezičkih modela, podelio je ključne ideje o kraju jedne ere u AI razvoju i nagovestio nove pravce istraživanja.

Konekcionizam1: Temelj modernog AI-a

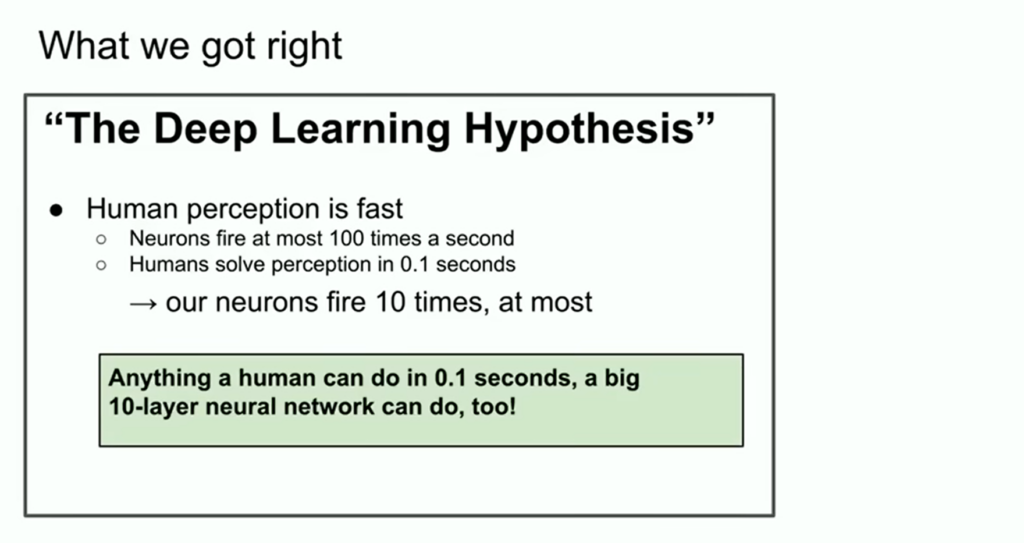

Sutskever započinje isticanjem konekcionizma kao osnovne ideje koja je izdržala test vremena. Ova teorija predlaže da se veštački neuroni mogu posmatrati kao aproksimacija bioloških neurona, što daje osnovu za verovanje da dovoljno velike neuronske mreže, čak i manjeg obima od ljudskog mozga, mogu postići mnoge sposobnosti karakteristične za ljude.

Ipak, Sutskever napominje ključnu razliku: ljudski mozak ima sposobnost samostalnog rekonfiguriranja, dok trenutni AI sistemi zavise od algoritama učenja koji zahtevaju ogroman broj podataka.

Era “pre-training” i njena neizbežna smrt

Prema Sutskeveru, trenutno se nalazimo u eri “pre-training”, koju su definisali modeli poput GPT-2, GPT-3.5 na osnovu istraživanja o zakonima skaliranja.

Sutskever iznosi smelu tvrdnju: Era pre-training će se neizbežno završiti.

Razlog za ovo leži u fundamentalnoj asimetriji: dok računarska snaga nastavlja da raste kroz bolje hardvere, algoritme i klastere, količina podataka ne raste istom brzinom. “Mi imamo samo jedan internet,” kaže Sutskever, opisujući podatke kao “fosilno gorivo AI-a” i sugerišući da smo već dostigli “vrhunac podataka” (Peak Data).

Šta dolazi posle: Prirodni primer za novu paradigmu

Gledajući u budućnost, Sutskever spekuliše o različitim pristupima koji bi mogli zameniti trenutnu paradigmu pre-training:

- Agenti (iako pomalo nejasno definisani)

- Sintetički podaci

- Inference time compute2 (vidljivo u modelu O1)

Posebno zanimljiv trenutak njegovog izlaganja bilo je poređenje odnosa veličine tela i mozga kod sisara. Sutskever ističe fascinantan detalj: dok većina sisara prati jednu liniju odnosa, hominidi (bliski srodnici ljudi) pokazuju drugačiji nagib u eksponentu skaliranja mozga u odnosu na telo.

Kroz logoritamsku skalu, Sutskever pokazuje da je moguće dostići drugačiju putanju (AI) razvoja. Ovo služi kao moćna metafora za AI polje: trenutno radimo sa prvim pristupom koji smo naučili da skaliramo, ali postoje fundamentalno drugačiji pristupi koji tek treba da budu otkriveni.

Intuicija naspram rezonovanja

Posebno važan deo Sutskeverovog izlaganja odnosi se na razliku između intuicije i rezonovanja. On objašnjava da smo treniranjem modela na ogromnim količinama podataka replicirali ljudsku intuiciju – onu vrstu procesiranja koja se dešava u prvih 0,1 sekundu reakcije. Međutim, rezonovanje je kvalitativno drugačije.

Sutskever naglašava kritičnu karakteristiku rezonovanja: “Što sistem više rezonuje, to postaje nepredvidljiviji.” Kao primer navodi šahovske AI sisteme, koji su često nepredvidivi čak i za najbolje ljudske igrače.

Prema njegovom viđenju, budući AI sistemi će:

- Biti stvarno agentični (za razliku od današnjih koji su tek “veoma, veoma blago agentični”)

- Moći da rezonuju na način koji će biti fundamentalno nepredvidiv

- Razumeti stvari iz ograničenih podataka

- Ne zbunjivati se u situacijama koje danas zbunjuju modele

- Potencijalno razviti samosvest (“jer zašto ne, samosvest je korisna”)

Zaključak: Na putu ka superinteligenciji

Sutskever zaključuje da ćemo, kada se sve ove sposobnosti ujedine, imati sisteme “radikalno drugačijih kvaliteta i svojstava“ od onih koji postoje danas. Iako ne navodi kada i kako će se to dogoditi, jasno sugeriše da je to neizbežna putanja razvoja veštačke inteligencije.

Tekst je motivisan predavanjem Ilya Sutskever-a na NeurIPS decembar 2024 in Vancouver, Canada, gde je jedna mala anegdota spomenuo i istakao svoje bivše saradnike Aleca Radforda, Jareda Kaplana i Daria Amodeia (nije spomenuo Sam Altmana!?), koji su to učinili mogućim, odnosno doveli do doba pre-treniranja.

- Konekcionizam je pristup proučavanju mentalnih procesa i kognicije koji koristi matematičke modele poznate kao konekcionističke mreže ili veštačke neuronske mreže koje se sastoje od procesorskih jedinica nalik na neurone i veza između različitih slojeva neurona. ↩︎

- “Inference time compute” odnosi se na računarske resurse i vreme potrebno za izvođenje inferencije koristeći model mašinskog učenja. Inferencija je proces pravljenja predviđanja ili odluka na osnovu novih, neviđenih podataka koristeći prethodno obučeni model. Ovo je različito od faze pretreninga, gde model uči iz skupa podataka ↩︎

AI Rezonovanje Od Chain-of-Thought Do Tree-of-Thought Pristupa -

[…] Još prirodnije i transparentnije procese razmišljanja […]